Mixture of Experts

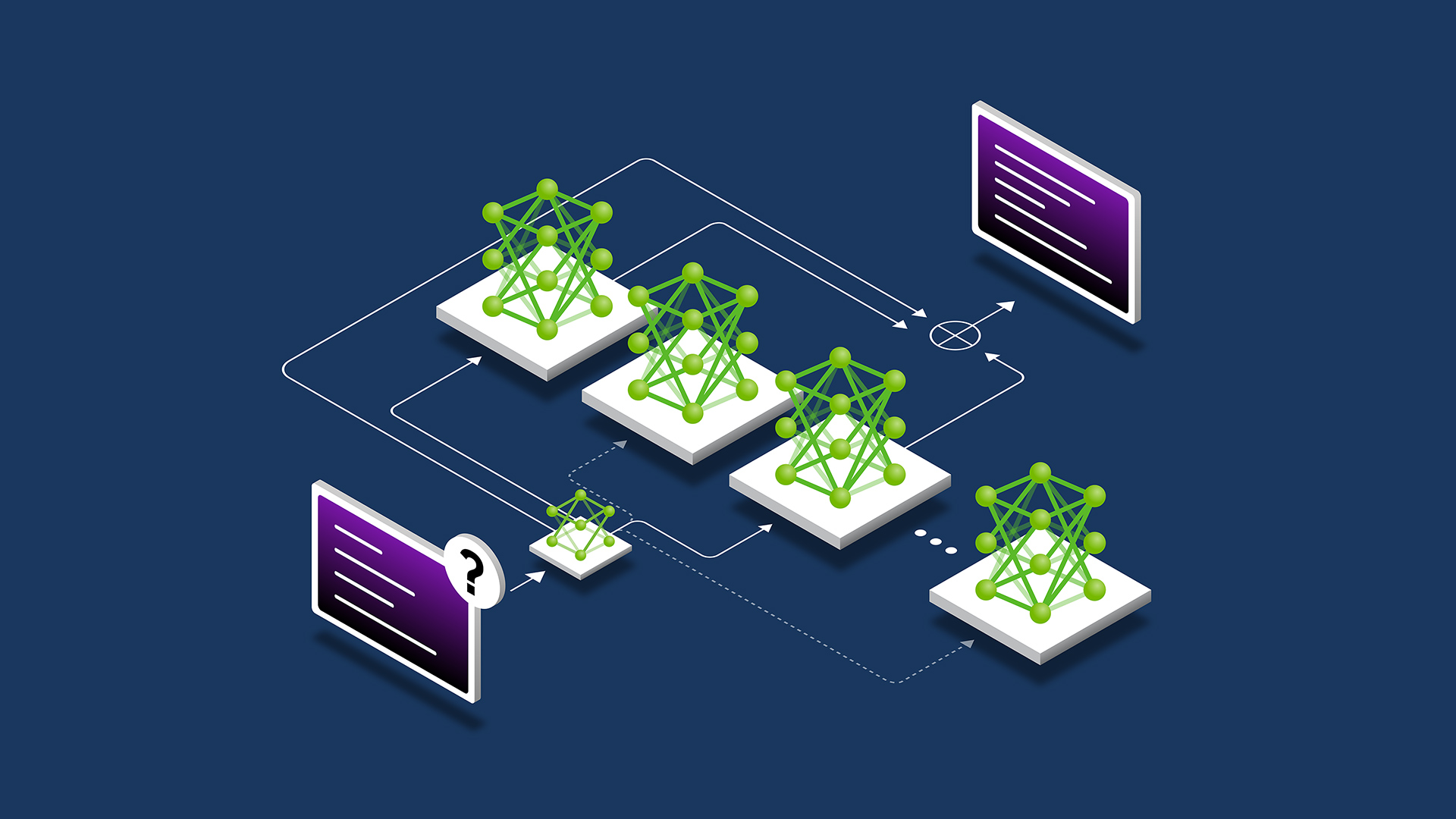

Mixture of Experts(MoE)는 모델의 특정 부분만 활성화하여 효율적인 학습과 추론을 가능하게 하는 기법입니다. 이는 모델의 규모를 크게 늘리면서도 계산 자원을 절약할 수 있게 해줍니다.

MoE는 크게 두 가지 요소로 구성됩니다:

-

전문가(Expert): 각 전문가들은 일반적으로 피드포워드 네트워크(FFN)로 구성되며, 서로 다른 전문가들이 다양한 입력 특징을 처리합니다.

-

게이트 네트워크(Gate Network) 또는 라우터(Router): 이 네트워크는 각 입력 토큰을 어떤 전문가에게 보낼지 결정합니다. 예를 들어, 특정 토큰은 두 번째 전문가에게, 다른 토큰은 첫 번째 전문가에게 라우팅됩니다.

MoE의 주요 이점은 다음과 같습니다:

-

효율적인 사전 학습: 동일한 계산 자원으로 더 큰 모델이나 데이터셋을 활용할 수 있어, 밀집(dense) 모델보다 빠르게 동일한 품질을 달성할 수 있습니다.

-

빠른 추론 속도: 동일한 파라미터 수를 가진 모델과 비교하여 추론 속도가 더 빠릅니다.

그러나 모든 전문가를 메모리에 로드해야 하므로 높은 VRAM이 필요하며, 미세 조정 시 여러 도전에 직면할 수 있습니다. 하지만 최근 연구에서는 MoE를 활용한 인스트럭션 튜닝이 유망한 결과를 보이고 있습니다.

1. MoE의 계산 자원 효율성

MoE 모델은 여러 개의 전문가(Expert)로 구성되지만, 모든 전문가가 동시에 활성화되는 게 아닙니다.

- 일반적인 Dense 모델은 모든 FFN(Feed-Forward Network) 레이어의 뉴런을 매번 사용하지만,

- MoE 모델은 게이트 네트워크(Gating Network)를 통해 일부 전문가만 활성화해서 연산을 수행합니다.

예를 들어, 모델이 8개의 전문가를 가지고 있고, 한 번에 2개만 활성화한다고 가정하면:

- Dense 모델에서는 100%의 연산이 수행되지만,

- MoE 모델에서는 전체의 25%만 연산합니다.

- 즉, 모델의 전체 파라미터 수는 크지만, 한 번의 연산에 필요한 FLOPs는 적어지는 효과가 있습니다.

2. MoE의 VRAM 사용량 증가

하지만 MoE 모델은 모든 전문가의 파라미터를 GPU 메모리에 로드해야 합니다.

- Dense 모델은 모델 전체 크기가 작아서 VRAM 부담이 적습니다.

- 반면, MoE 모델은 여러 전문가가 존재하므로 전체 모델 크기는 커지고, 이를 저장할 VRAM이 더 필요하게 됩니다.

3. MoE의 장점과 단점 정리

| Dense 모델 | MoE 모델 | |

|---|---|---|

| VRAM 사용량 | 상대적으로 적음 | 더 많음 (모든 전문가를 로드해야 함) |

| 연산량(FLOPs) | 모든 파라미터가 활성화됨 | 일부 전문가만 활성화되어 연산 절감 |

| 속도 | 크기가 크면 연산 부담이 커짐 | 연산량이 줄어들어 속도가 개선됨 |

| 확장성 | 모델 크기 증가 시 학습이 어려워짐 | 큰 모델을 더 효율적으로 운용 가능 |

MoE는 트랜스포머 모델의 FFN 레이어를 MoE 레이어로 대체하여 구현됩니다. 각 MoE 레이어는 게이트 네트워크와 여러 전문가들로 구성되며, 게이트 네트워크는 각 토큰을 적절한 전문가에게 라우팅합니다. 이러한 구조는 모델의 확장성과 효율성을 크게 향상시킵니다.

최근에는 Mistral AI의 Mixtral 8x7B와 같은 대규모 MoE 모델이 공개되어, 오픈 AI 커뮤니티에서 큰 관심을 받고 있습니다.

최근 Mixture of Experts(MoE) 기법을 활용한 최신 모델들은 다음과 같습니다:

GLaM (Giant Language Model)

구글이 개발한 1.2조 파라미터 규모의 언어 모델로, 각 MoE 레이어에서 64개의 전문가 중 상위 2개를 선택하여 연산합니다.

Switch Transformer

구글이 개발한 모델로, 각 MoE 레이어에서 상위 1개의 전문가만 활성화하여 연산 효율성을 높였습니다.

NLLB-200 (No Language Left Behind)

Meta AI가 개발한 200개 언어를 지원하는 기계 번역 모델로, 각 MoE 레이어에서 계층적 MoE를 활용하여 번역 품질을 향상시켰습니다.

Mixtral 8x7B

Mistral AI가 2023년 12월에 공개한 8명의 전문가를 가진 46.7억 파라미터 규모의 언어 모델로, Apache 2.0 라이선스로 배포되었습니다.

DBRX

Databricks가 2024년 3월에 공개한 1320억 파라미터 규모의 언어 모델로, 16명의 전문가와 스파시티 4를 특징으로 합니다.